Wstęp: Alan, który umiał czytać Enigmę

Alan Turing nie był poetą. Ale umiał czytać język tak, jak nikt przed nim - statystycznie, bez złudzeń.

Gdy inni widzieli szyfr, on widział wzorzec. Gdy inni łamali sobie głowy, on łamał Enigmę - przy pomocy maszyny liczącej, logiki i… prawdopodobieństw1.

To właśnie Turing, jako jeden z pierwszych, traktował język nie jako dar boski, lecz jako sygnał - do rozkładu, analizy, dekonstrukcji. Zasiewa ziarno, które po latach wykiełkowało: najpierw w informatyce, potem w lingwistyce maszynowej, a wreszcie - w neuronowych modelach języka.

1. Co to jest determinizm?

Determinizm to pogląd, że każda przyczyna ma jeden przewidywalny skutek2. W informatyce to znaczy: ten sam kod, ten sam stan wejściowy, ten sam wynik. Programy, procesory, pamięci - to wszystko jest zbudowane na zasadach deterministycznych. Każde uruchomienie algorytmu powinno dać ten sam rezultat.

Więc jakim cudem model GPT potrafi odpowiadać dwa razy inaczej na to samo pytanie?

2. Informatyka jest deterministyczna - ale LLM nie zawsze się zachowuje jak program

Sieci neuronowe działają na deterministycznych maszynach, ale generują odpowiedzi, które są... dziwnie nieprzewidywalne. To dlatego, że LLM to nie algorytm krok po kroku, tylko symulacja zjawiska statystycznego3.

Model GPT nie przeszukuje bazy danych. On aproksymuje4 najbardziej prawdopodobną kontynuację danego wejścia w przestrzeni znaczeń.

3. Co to znaczy, że LLM generuje odpowiedź? - czyli język, który uczy maszynę znaczenia

LLM nie uczy się zdań. Nie zna reguł gramatyki. Nie ma zdefiniowanych znaczeń. Zamiast tego analizuje ogromne ilości tekstu, by wyłapać sąsiedztwa słów.

Z tych zależności powstaje przestrzeń znaczeń. Każde słowo ma swój embedding5 - punkt w tej przestrzeni. Prompt, który wpisujesz, to nie pytanie. To wektor. Model przelicza go i stara się odnaleźć najbardziej pasujące znaczenie odpowiedzi, a dopiero potem zamienia to znaczenie z powrotem na język naturalny.

To nie jest kopiowanie wiedzy. To symulowane rozumienie przez aproksymację znaczeń.

4. Skąd się bierze losowość?

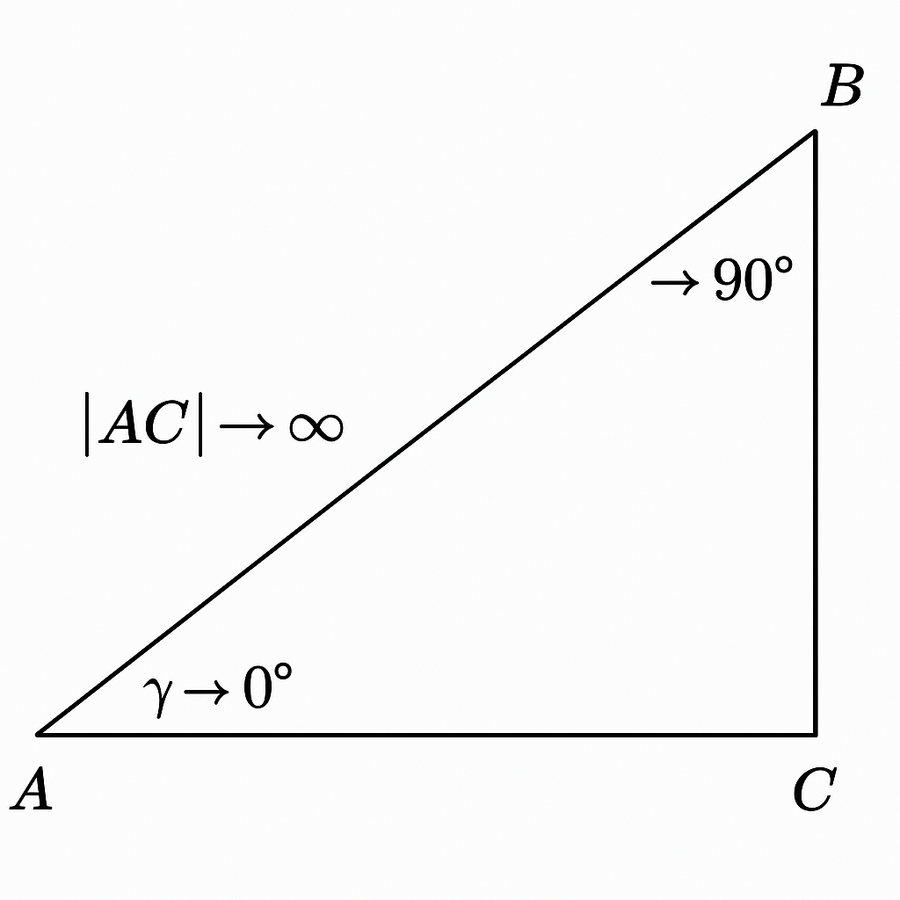

Model GPT generuje kolejne tokeny na podstawie rozkładu prawdopodobieństw. Parametr temperature steruje tą losowością6. Sampling pozwala dodać kontrolowaną niepewność do deterministycznego procesu.

5. Dlaczego pojawiają się błędy? I czym są halucynacje?

A. Rozkład niepewności

Model zgaduje najbardziej prawdopodobny token. Ale nie sprawdza faktów. Może wygenerować gramatycznie poprawny, ale całkowicie nieprawdziwy tekst.

B. Halucynacje

To właśnie te przypadki, gdy LLM tworzy odpowiedzi pozornie prawdziwe, ale całkowicie zmyślone7. Dzieje się tak, bo prompt zasugerował kontekst, a model nie ma mechanizmu jego weryfikacji.

6. Czy LLM myśli?

Nie. Model nie ma świadomości, pamięci trwałej ani intencji. On istnieje tylko wtedy, gdy odpowiada na prompt. To nie SkyNet - to efemeryczna funkcja statystyczna.

C. Uważaj, o co pytasz

LLM wyciąga z prompta więcej, niż ci się wydaje. Jeśli pytanie zawiera założenie - zostanie ono rozwinięte. Jeśli jest tendencyjne - otrzymasz tendencyjną odpowiedź.

Zanim zapytasz AI, zapytaj siebie: czy moje pytanie nie prowadzi mnie tylko do potwierdzenia własnych przekonań?

Zakończenie: Alan, który patrzył dalej niż my

Alan Turing nie stworzył sztucznej inteligencji. Ale wiedział, że jego praca zmierza w tym kierunku. On zaproponował test Turinga8 - próbę rozróżnienia człowieka od maszyny.

Dziś wiele osób tego testu by nie przeszło. A maszyny? Coraz częściej tak.

Nie dlatego, że rozumieją. Ale dlatego, że symulują znaczenie z precyzją, która potrafi nas zmylić.

Glosariusz

Aproksymacja - Przybliżone rozwiązanie uzyskane na podstawie danych lub estymacji.

Embedding - Reprezentacja tekstu w przestrzeni wektorowej, pozwalająca modelowi rozumieć relacje między słowami.

Prompt - Tekst wejściowy, który użytkownik przekazuje modelowi językowemu.

Token - Fragment tekstu przetwarzany przez model (np. słowo, sylaba, znak).

Sampling - Losowe wybieranie tokenu z rozkładu prawdopodobieństw.

Temperature - Parametr kontrolujący poziom kreatywności modelu.

Halucynacja - Wygenerowanie przez model fałszywej, ale gramatycznie poprawnej odpowiedzi.

Deterministyczność - Cecha systemu, w którym te same dane wejściowe dają zawsze ten sam wynik.

LLM Large Language Model - duży model językowy, trenowany na wielkich zbiorach danych.

Przypisy

- Turing, A. M. (1936). On Computable Numbers, with an Application to the Entscheidungsproblem.

- Laplace, P. S. - klasyczna definicja determinizmu.

- Sieci neuronowe tworzą reakcje na wejście, nie wykonują reguł jak tradycyjne programy.

- Aproksymacja to proces przybliżania - fundament działania LLM.

- Embedding to mapa znaczeń, nie definicji.

- Temperature reguluje, czy model będzie przewidywalny czy kreatywny.

- Halucynacja: fałszywa, ale wiarygodna odpowiedź modelu.

- Turing, A. M. (1950). Computing Machinery and Intelligence.